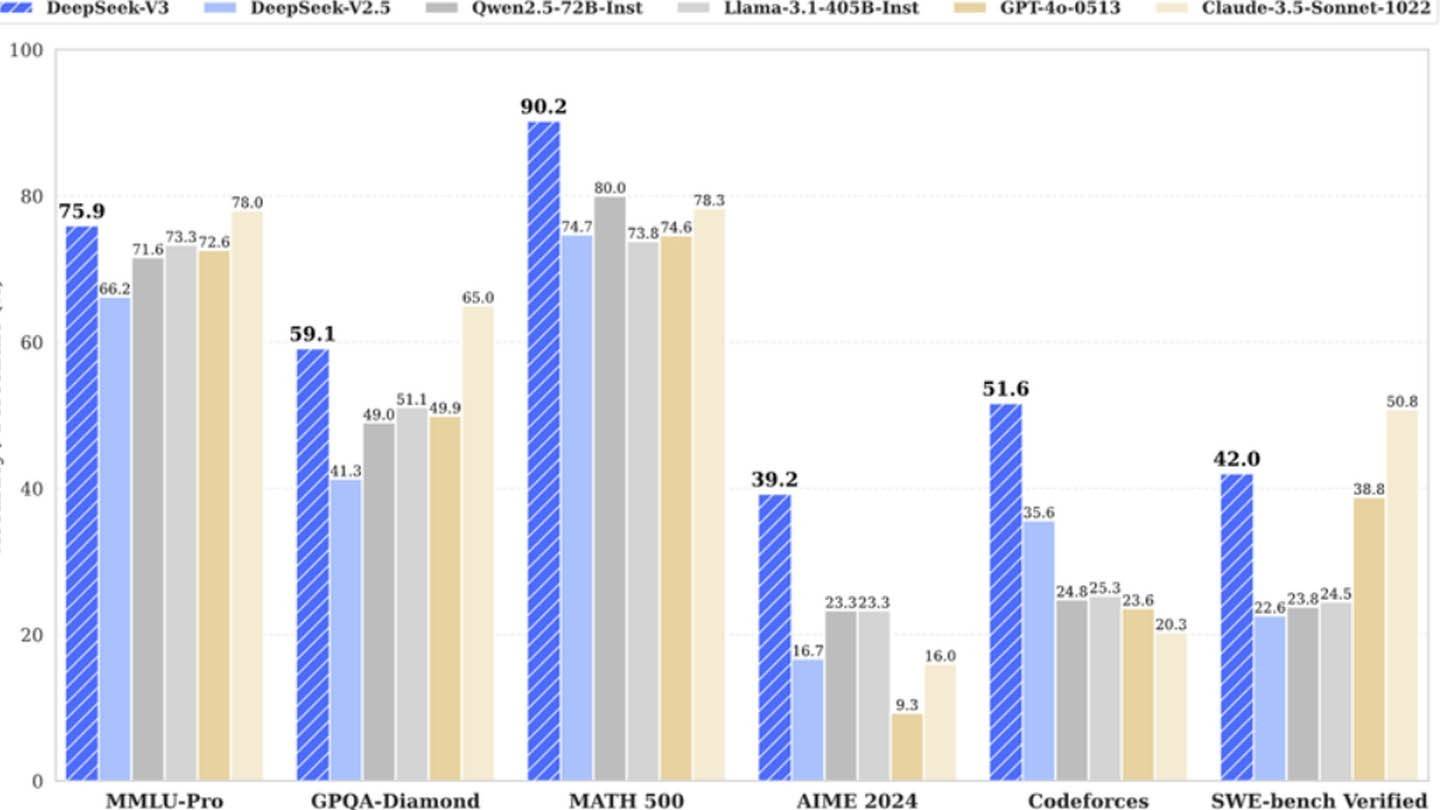

DeepSeek의 놀랍게도 저렴한 AI 모델은 업계 거인에게 도전합니다. 중국 스타트 업의 Deepseek V3는 멀티 토닉 예측 (MTP), 256 개의 신경망을 활용하는 전문가 (MOE)와 같은 혁신적인 기술을 자랑하며, MLA (Multi-Head Wentent Interetion)는 2048 년을 사용하여 6 백만 달러의 훈련 비용을 주장했습니다. gpus. 그러나이 겉보기에 낮은 수치는 Semianalysis의 결과와 크게 대조되는 경우, 여러 데이터 센터에서 약 50,000 개의 NVIDIA GPU (H800, H100 및 H20 단위 포함)의 대규모 인프라가 대략 16 억 달러의 총 서버 투자를 나타내며 가까운 운영 비용의 총 투자를 나타냅니다. $ 944 백만.

이미지 : ensigame.com

이미지 : ensigame.com

이미지 : ensigame.com

이미지 : ensigame.com

High-Flyer 헤지 펀드의 자회사 인 Deepseek는 데이터 센터를 소유하여 빠른 혁신과 최적화를 촉진합니다. 자체 자금을 지원하는 자연과 높은 급여 (일부 연구자들은 매년 130 만 달러 이상을 벌 수 있음)는 중국의 최고 인재를 유치하여 성공에 기여합니다. 초기 6 백만 달러는 사전 훈련 GPU 비용, 연구, 개선, 데이터 처리 및 인프라 비용 만 반영합니다. AI 개발에 대한 DeepSeek의 실제 투자는 5 억 달러를 초과합니다. 이러한 상당한 투자에도 불구하고, 린 구조는 더 큰 관료적 경쟁자에 비해 효율적인 혁신을 허용합니다.

이미지 : ensigame.com

이미지 : ensigame.com

이미지 : ensigame.com

이미지 : ensigame.com

DeepSeek의 "혁신적인 예산"주장이 촉발되었지만, 그 성공은 잘 자금을 지원 받고 독립적 인 AI 회사의 경쟁 잠재력을 강조합니다. DeepSeek의 R1은 5 백만 달러의 비용이 들었고 ChatGpt-4는 1 억 달러가 소요되었으며 DeepSeek의 상대적 비용 효율성을 상당한 전반적인 투자로도 강조하는 대조는 대조적입니다.